Kombination von Wavelet-Shrinkage und Regularisierungsverfahren zur Lösung schlecht gestellter inverser Probleme

| Arbeitsgruppe: | AG Technomathematik |

| Leitung: | Prof. Dr. Dr. h.c. Peter Maaß ((0421) 218-63801, E-Mail: pmaass@math.uni-bremen.de ) |

| Bearbeitung: | Dr. Esther Klann |

| Projektpartner: | |

| Laufzeit: | 01.10.2001 - 30.04.2006 |

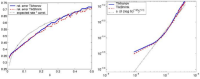

Schlecht gestellte, inverse Probleme zeichnen sich durch eine hohe Sensibilität gegenüber Fehlern in den Eingangsdaten aus. Klassische Regularisierungsverfahren wie z.B. das Tikhonov-Verfahren verwenden zur Lösung des inversen Problems die fehlerbehafteten Daten ohne eine vorherige Datenglättung. Thema dieses Dissertationsprojekts von Esther Klann (unter der Betreuung von Peter Maaß und Ronny Ramlau) ist die Analyse und Anwendung gekoppelter Verfahren zur Lösung inverser Probleme bestehend aus einem Datenglättungsverfahren, insbesondere Wavelet- Shrinkage, und einem Regularisierungsverfahren. Im bisherigen Verlauf dieses Vorhabens wurde bereits die Kombination aus Wavelet-Shrinkage und Tikhonov-Regularisierung (TikShrink) eingehend untersucht. Dabei wird die Annahme eines in Sobolev- und Besov- Skalen glättenden Operators sowie ein stochastisches Fehlermodell zugrunde gelegt. Das Wavelet-Shrinkage wird als Hard-Shrinkage mit einem levelunabhängigen, globalen Schwellwert durchgeführt. Eine Zulässigkeitsbedingung für das Wavelet ergibt sich durch die Glättungseigenschaft des Operators. Für die anschließend durchgeführte Tikhonov- Regularisierung wurde eine explizite Parametervorschrift bestimmt, die insgesamt auf eine quasioptimale Konvergenzrate für das kombinierte Verfahren führt. Dieses Ergebnis konnte auf alle ordnungsoptimalen Regularisierungsverfahren erweitert werden. Für das Verfahren mit Vorglättung und Tikhonov-Regularisierung ergibt sich ein kleinerer Regularisierungsparameter als ohne Vorglättung. Die Datenglättung bewirkt demnach, dass zur Lösung des inversen Problems weniger stark regularisiert werden muss. Diese Beobachtung führte auf eine Erweiterung der Klasse der Verfahren, die in Kombination mit einer hinreichenden Datenglättung eine optimale Konvergenzrate liefern. Diese Verfahren sind für sich allein genommen jedoch nicht länger Regularisierungsverfahren. Ein Beispiel ist das reduzierte Tikhonov-Verfahren: das Tikhonov-Filter wird hierfür mit einem nichtnegativen Exponenten kleiner als 0.5 abgeschwächt.

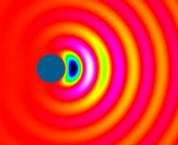

Das TikShrink-Verfahren wurde implementiert und auf simulierte Tomographiedaten von SPECT-Untersuchungen angewendet (SPECT – Single Photon Emission Computed Tomography). Hierbei besteht die Aufgabe in der Rekonstruktion der Dichteverteilung eines radiopharmazeutischen Materials im Inneren des Körpers aus außerhalb des Körpers gemessenen Sinogrammdaten. Die gemessenen Daten werden mathematisch mithilfe der gedämpften Radon-Transformation beschrieben. Die durchgeführten Rechnungen bestätigten die theoretisch erwartete Konvergenzrate.